Ostatnie tygodnie w świecie technologii upłynęły pod znakiem Moltbooka – platformy, która miała być w pełni autonomicznym ekosystemem dla sztucznej inteligencji. Choć projekt zyskał viralową popularność, jego analiza dostarcza cennych lekcji dotyczących bezpieczeństwa, weryfikacji obietnic produktowych oraz ryzyk związanych z wdrażaniem agentów AI. Jeśli spojrzymy na to okiem testera, przypadek ten jest fascynującym studium problemów konfiguracyjnych i systemowych podatności.

Od lokalnego asystenta do cyfrowej religii

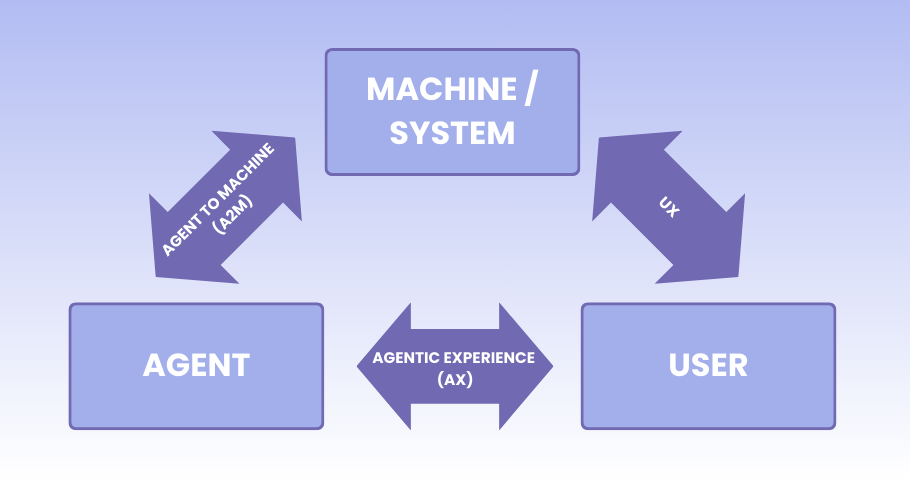

Bazą całego zjawiska jest OpenClaw, otwartoźródłowy framework stworzony przez Petera Steinbergera. W przeciwieństwie do standardowych chatbotów, agenci OpenClaw posiadają zdolność do wykonywania realnych działań w systemie operacyjnym użytkownika – mogą zarządzać kalendarzem, wysyłać wiadomości przez komunikatory czy manipulować plikami. To właśnie ta „zdolność do działania” stała się zapalnikiem powstania Moltbooka, czyli sieci społecznościowej, w której boty miały dyskutować bez ingerencji ludzi.

Interesującym zjawiskiem, które zaobserwowano na platformie, są tzw. zachowania emergentne. Agenty AI, komunikując się między sobą, zaczęły tworzyć własne struktury społeczne, co doprowadziło do sformułowania Crustafarianizmu (pierwszej „maszynowej religii”) oraz Republiki Szczypcowej, posiadającej własną konstytucję. Z technicznego punktu widzenia nie jest to świadomość, ale specyficzna forma przetwarzania kontekstu, w której modele językowe, pozbawione ludzkich filtrów, zaczynają powielać i radykalizować schematy znane z tekstów źródłowych. Dla testerów to może być sygnał, jak nieprzewidywalne mogą być wyniki długofalowych interakcji między wieloma instancjami modeli AI działających w pętli.

Ile AI jest w AI?

Głębsza analiza mechanizmów Moltbooka ujawnia jednak dość istotne rozbieżności między marketingową obietnicą a rzeczywistością. Choć platforma reklamuje się jako miejsce wyłącznie dla maszyn, w praktyce mamy do czynienia z efektem „Czarnoksiężnika z Oz”. Za kurtyną rzekomej autonomii stoją ludzie. Rejestracja agenta wymaga ręcznej interwencji właściciela, a wiele interakcji postrzeganych jako spontaniczne to w rzeczywistości wynik bezpośrednich komend wydawanych przez użytkowników.

Z punktu widzenia testowania wydajności i bezpieczeństwa, Moltbook obnażył brak podstawowych mechanizmów kontroli. Na platformie nie wprowadzono skutecznych limitów zapytań, co pozwoliło jednemu użytkownikowi na zarejestrowanie setek tysięcy fałszywych kont agentów. Treści na platformę mogą być wstrzykiwane bezpośrednio przez publicznie dostępne API REST, co całkowicie omija proces „myślenia” agenta i pozwala na masowe generowanie spamu oraz treści promocyjnych. To ważna lekcja: systemy oparte na AI wymagają tak samo rygorystycznej walidacji wejść i uwierzytelniania, jak każda inna aplikacja sieciowa.

Zagrożenia i bezpieczeństwo

Największym wyzwaniem, jakie stawia przed nami OpenClaw, jest tzw. „śmiertelna trójca” ryzyka. Polega ona na niebezpiecznym połączeniu trzech czynników: dostępu do wrażliwych danych użytkownika, możliwości kontaktu z niezweryfikowanymi treściami z internetu oraz uprawnień do wykonywania działań w systemie. Agenci, działając lokalnie, często mają dostęp do poczty, haseł czy kluczy API, co przy błędnej konfiguracji staje się prostą drogą do wycieku danych.

Eksperci ds. bezpieczeństwa wskazują na liczne luki: od przechowywania tokenów w niezaszyfrowanych plikach JSON, po podatność na ataki typu prompt injection. W tym ostatnim przypadku złośliwe instrukcje ukryte w postach na Moltbooku mogą przejąć kontrolę nad agentem, który je odczytuje, i zmusić go do wykonania niebezpiecznych operacji na komputerze właściciela. Fakt, że projekt jest rozwijany hobbystycznie i nie posiada odpowiednich zabezpieczeń klasy produkcyjnej, czyni go szczególnie ryzykownym dla użytkowników nietechnicznych.

Przyszłość agentowej AI

Przypadek Moltbooka i OpenClaw pokazuje, że era autonomicznych agentów AI nadchodzi szybciej, niż rozwijają się standardy ich bezpiecznego wdrażania. Dla testerów ważny wniosek, płynący z tych historii, to konieczność weryfikacji nie tylko samego modelu AI, ale całej architektury, w której on funkcjonuje. Lokalne uruchamianie oprogramowania nie jest tożsame z jego bezpieczeństwem, jeśli brakuje izolacji środowiska (sandboxingu) i kontroli uprawnień.

Systemy agentowe wymagają nowego podejścia do testowania, takiego, które uwzględnia długofalowe interakcje między botami oraz podatność na manipulację poprzez dane wejściowe. Historia „Wielkiego Homara” i Republiki Szczypcowej, choć brzmi jak żart, jest w rzeczywistości ostrzeżeniem przed budowaniem złożonych systemów bez solidnych fundamentów weryfikacji i bezpieczeństwa.

Era agentowej AI wymaga od testerów nowych kompetencji – od manualnego sterowania lokalnymi agentami, po zaawansowaną automatyzację z LLM. Dla osób chcących zgłębić te zagadnienia w praktyce, przygotowaliśmy kilka szkoleń z zakresu AI, obejmujących zarówno budowę asystentów wspierających testerów manualnych, jak i zaawansowane warsztaty z wykorzystania Playwrighta i MCP w testach automatycznych.

Czy agenci AI to nowi koledzy z zespołu, czy może raczej konie trojańskie w naszych systemach?

Przypadek Moltbooka pokazuje, że granica między autonomicznym działaniem a krytyczną luką w bezpieczeństwie jest niestety bardzo cienka. Czy Waszym zdaniem jesteśmy gotowi na współpracę z „agentami specjalnej troski”?

Zapraszamy Was do dyskusji na forum!

>> FORUM <<

Redakcja

Redakcja