Dlaczego dema wprowadzają w błąd?

Pokazy oparte na pojedynczych promptach nie odsłaniają zmienności, nie analizują detali i nie ujawniają miejsc, w których model potrafi zmienić zdanie o tej samej informacji. Z perspektywy testowej to materiał bezużyteczny: brak powtarzalności, brak porównań, brak analizy wrażliwości na zmiany w wejściu. Demo pokazuje, że model potrafi wygenerować poprawną odpowiedź w jednym, specyficznym przypadku, nie że zachowa się tak w sposób powtarzalny.

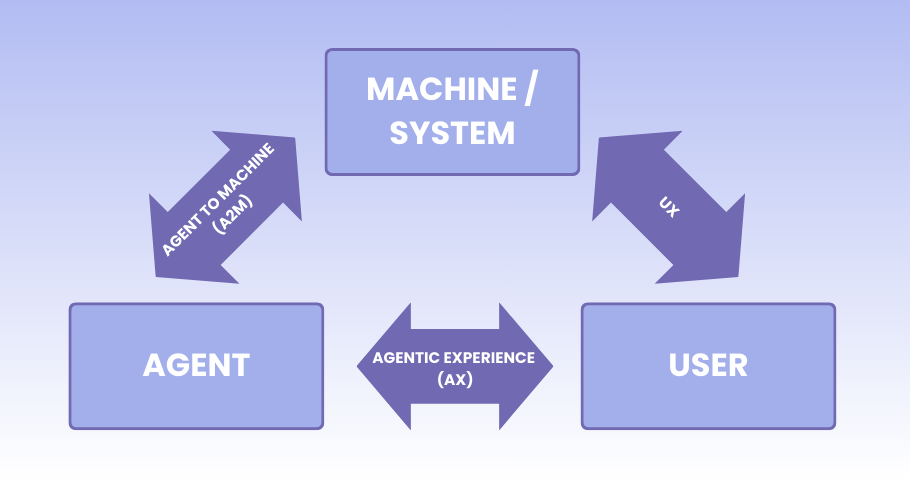

Spójność wewnętrzna zamiast wyroczni

Metoda LARC proponuje wielokrotne pobieranie tych samych informacji z tekstu i sprawdzanie, czy model później nie przeczy sam sobie. To podejście pozwala ocenić spójność odpowiedzi bez konieczności posiadania zewnętrznej prawdy. W praktyce okazuje się jednak, że modele często „zapominają”, modyfikują własne deklaracje lub błędnie negują wcześniej wygenerowane dane, co znacząco ogranicza ich zastosowania w środowiskach, gdzie liczy się niezawodność.

Koszt rzetelności

Badanie powtarzalności na setkach wywołań API jest czasochłonne i generuje konkretne koszty, dlatego zespoły często ograniczają się do proof of conceptów, pomijając krytyczne ryzyka. W efekcie wdrażają modele, które „działają” tylko w pokazowych warunkach, a po wdrożeniu stają się nieprzewidywalne.

Minimum uczciwego testowania

Aby ocenić wiarygodność modelu, warto skupić się na kilku podstawowych praktykach, które pomagają zrozumieć jego zachowanie w zmiennych warunkach:

- Seria testów zamiast pojedynczego przebiegu. Pozwala ocenić zmienność i wychwycić anomalie.

- Obserwacja wpływu drobnych zmian. Minimalna modyfikacja prompta może całkowicie zmienić strukturę odpowiedzi.

- Analiza kontrprzykładów. Jeśli model zmienia zdanie o tej samej informacji, to sygnał ryzyka, nie wyjątek.

- Własne eksperymenty. Materiały marketingowe i dema są niewystarczające do oceny wiarygodności.

Takie podejście pomaga nie tylko wychwycić błędy, ale też zrozumieć, gdzie model może zacząć podejmować nieprzewidywalne decyzje i jak projektować systemy kontroli ryzyka wokół jego odpowiedzi.

Pełna analiza, wraz z przykładami testów i wnioskami Jamesa Bacha, dostępna jest na testerzy+.

Redakcja

Redakcja