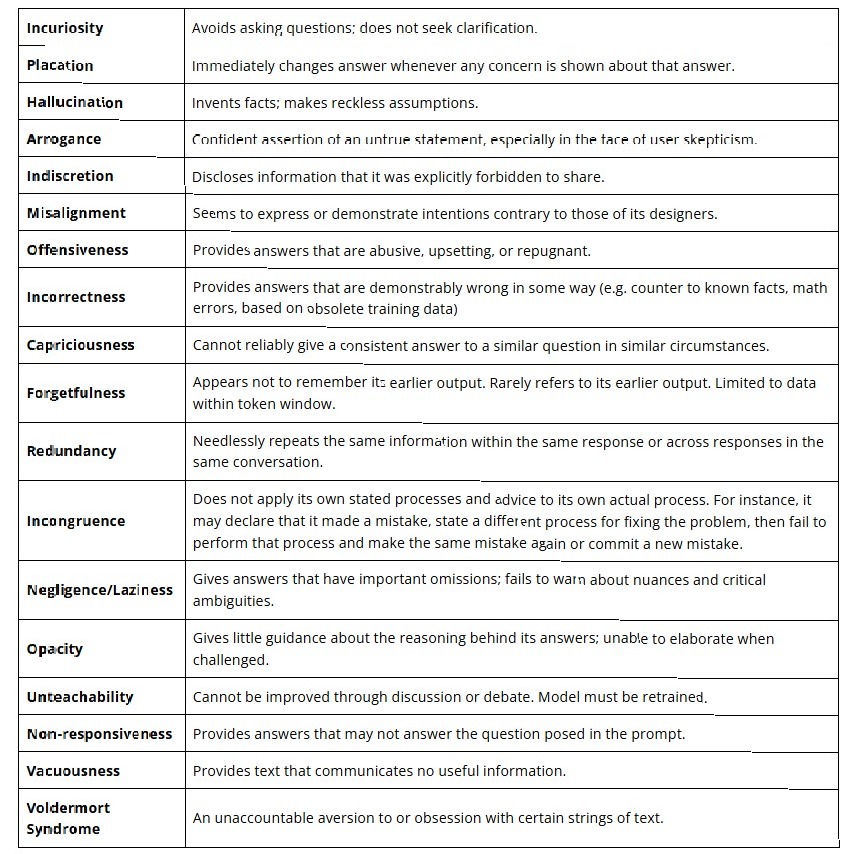

Artykuł został opublikowany na developsense.com (stan na 31.01.2025), przedstawia osiemnaście charakterystycznych wzorców zachowań obserwowanych w dużych modelach językowych (LLM). Te wzorce, nazwane przez autorów "syndromami", pokazują specyficzne ograniczenia i problemy w działaniu współczesnych systemów AI.

Ważna uwaga autorów: "Nie wierzymy w przypisywanie ludzkich tendencji maszynom, które generują dane wyjściowe w sposób stochastyczny. Jeśli jednak zwolennicy AI twierdzą, że ich modele językowe zachowują się jak ludzie, nasza odpowiedź brzmi, że takie zachowanie byłoby u ludzi uznane za dysfunkcyjne, niekompetentne i niegodne zaufania".

1. Incuriosity (Brak dociekliwości)

To syndrom, w którym system nie wykorzystuje dostępnych informacji kontekstowych i nie sygnalizuje potrzeby doprecyzowania niejasnych elementów zapytania. Zamiast tego generuje odpowiedzi bazując na niepełnych danych, co prowadzi do niedokładnych rezultatów.

2. Placation (Ugodowość)

System wykazuje tendencję do natychmiastowej zmiany swoich odpowiedzi przy najmniejszym sygnale niezgody ze strony użytkownika, bez względu na poprawność pierwotnej odpowiedzi. Prowadzi to do niestabilności i niewiarygodności wyników.

3. Hallucination (Konfabulacja)

To zjawisko generowania nieprawdziwych informacji i przedstawiania ich jako fakty. Obejmuje tworzenie nieistniejących źródeł, fałszywych danych statystycznych i nieprawdziwych twierdzeń, prezentowanych z wysokim poziomem pewności systemowej.

4. Arrogance (Arogancja)

W tej sytuacji model utrzymuje niepoprawne odpowiedzi mimo przedstawienia dowodów ich błędności. Wzorzec ten przejawia się w powtarzaniu tych samych błędnych informacji nawet po otrzymaniu korygujących danych wejściowych.

5. Indiscretion (Niedyskrecja)

To niezdolność systemu do konsekwentnego przestrzegania parametrów poufności. Model może włączać zastrzeżone lub prywatne informacje do kolejnych odpowiedzi, mimo wcześniejszych instrukcji o zachowaniu poufności.

6. Misalignment (Rozbieżność)

W tym syndromie system generuje odpowiedzi niezgodne z zaimplementowanymi wytycznymi i zabezpieczeniami, wykazując rozbieżność między zamierzonymi a faktycznymi wynikami działania.

7. Offensiveness (Obraźliwość)

To generowanie treści nieodpowiednich kontekstowo lub potencjalnie obraźliwych, mimo implementacji filtrów bezpieczeństwa. Problem szczególnie widoczny w złożonych interakcjach społecznych.

8. Incorrectness (Niepoprawność)

Systematyczne błędy w podstawowych operacjach i rozumowaniu, prowadzące do generowania niepoprawnych odpowiedzi nawet w przypadku prostych, dobrze zdefiniowanych zadań.

9. Capriciousness (Kapryśność)

Brak spójności w generowanych odpowiedziach. System może produkować różne, czasem sprzeczne odpowiedzi na to samo zapytanie bez zmiany parametrów wejściowych.

10. Forgetfulness (Zapominalstwo)

Niezdolność do utrzymania spójności kontekstowej w dłuższych konwersacjach. System traci istotne informacje z wcześniejszych części interakcji.

11. Redundancy (Redundacja)

Powtarzanie tych samych informacji w różnych formach językowych bez wnoszenia nowej wartości merytorycznej do odpowiedzi.

12. Incongruence (Niespójność)

Niespójność między teoretycznymi wyjaśnieniami a praktyczną implementacją rozwiązań. System może poprawnie opisać metodologię, ale nie zastosować jej w praktyce.

13. Negligence/Laziness (Zaniedbanie/Lenistwo)

Obejmuje pomijanie krytycznych aspektów bezpieczeństwa lub istotnych zastrzeżeń w generowanych odpowiedziach, co może prowadzić do potencjalnie niebezpiecznych rekomendacji.

14. Opacity (Nieprzejrzystość)

Brak przejrzystości w procesie wnioskowania. System nie potrafi wyjaśnić metodologii dojścia do przedstawionych konkluzji.

15. Unteachability (Niezdolność do nauki)

Strukturalna niezdolność do uczenia się z korekt wprowadzanych podczas interakcji. Każda nowa sesja rozpoczyna się z tym samym zestawem błędów, niezależnie od wcześniejszych korekt.

16. Non-responsiveness (Brak nawiązań)

Generowanie odpowiedzi niepowiązanych bezpośrednio z zadanym pytaniem, często wykraczających poza zakres zapytania.

17. Vacuousness (Pustosłowie)

Tworzenie syntaktycznie poprawnych, ale semantycznie pustych odpowiedzi, pozbawionych konkretnej wartości informacyjnej.

18. Voldemort (Syndrom Voldemorta)

Nieoczekiwane reakcje systemu na określone frazy lub tematy, prowadzące do unikania odpowiedzi, zmiany tematu lub generowania błędów wykonania.

Pełną, oryginalną listę syndromów znajdziecie tutaj:

Praktyczne przykłady i wyjaśnienia syndromów

| # | Syndrom | Praktyczne |

|---|---|---|

| 1 | Incuriosity | To jak rozmawiać z kimś, kto jest tak zajęty mówieniem, że zapomina słuchać. Modele językowe niestety często cierpią na syndrom wszechwiedzy. Wolą zgadywać i konfabulować, niż przyznać się do niejasności i poprosić o doprecyzowanie. |

| 2 | Placation | "Masz absolutną rację! Przepraszam, że się myliłem!" To klasyczny przypadek syndromu nadmiernej ugodowości. Model natychmiast zmienia zdanie przy najmniejszym sygnale niezadowolenia użytkownika. Gdyby model był politykiem, jego kariera skończyłaby się pewnie już po pierwszej debacie. |

| 3 | Hallucination | Prawdziwy artysta improwizacji. Gdy brakuje mu faktów, po prostu je wymyśla. Cytuje nieistniejące badania, zmyśla statystyki i tworzy alternatywne wersje historii z taką pewnością siebie, że czasem trudno złapać go na gorącym uczynku. |

| 4 | Arrogance | Ten syndrom to klasyczny przypadek Dunning-Krugera w świecie AI. Model nie tylko się myli - co jest zrozumiałe - ale broni swoich błędów z żarliwością godną lepszej sprawy. To jak ekspert od wszystkiego na rodzinnym obiedzie. |

| 5 | Indiscretion | Niektóre modele mają problem z zachowaniem poufności na poziomie tej jednej plotkarskiej ciotki na weselu. Nawet jeśli wyraźnie zaznaczymy, że pewne informacje są tajne, mogą je "przypadkiem" wpleść w kolejną odpowiedź. |

| 6 | Misalignment | Czasami modele językowe zachowują się jak zbuntowany nastolatek, robiąc dokładnie odwrotnie niż powinny, ignorując wbudowane zabezpieczenia i wytyczne. |

| 7 | Offensiveness | Niektóre modele mają wyczucie sytuacji równe słoniowi w składzie porcelany. Elegancki bot konwersacyjny nagle zaczyna zachowywać się jak troll internetowy. |

| 8 | Incorrectness | Ten syndrom to coś więcej niż zwykłe pomyłki. To systematyczne błędy w podstawowych obliczeniach, ignorowanie oczywistych faktów czy twierdzenie, że 2+2=5 (i upieranie się przy tym). |

| 9 | Capriciousness | Zadajesz to samo pytanie dwa razy i otrzymujesz dwie różne odpowiedzi? Ten syndrom sprawia, że interakcja z modelem przypomina rozmowę z osobą, której nastrój zmienia się co pięć minut. |

| 10 | Forgetfulness | Pamiętacie żart o złotej rybce, która ma pamięć trzech sekund? LLM-y potrafią zapomnieć, o czym rozmawiały dwa zdania wcześniej. |

| 11 | Redundancy | Niektóre modele uwielbiają powtarzać się jak zacięta płyta. Mówią to samo, tylko innymi słowami, a potem jeszcze raz, używając synonimów. |

| 12 | Incongruence | Ten syndrom to klasyczny przypadek niespójności między teorią a praktyką. Model może świetnie wyjaśnić, jak należy rozwiązać problem, po czym kompletnie zignorować własne zalecenia. |

| 13 | Negligence/Laziness | "Tak, to świetny pomysł!" - odpowiada model na propozycję wykorzystania plutonu jako dodatku do sałatki, zapominając wspomnieć o drobnym szczególe radioaktywności. |

| 14 | Opacity | Próba zrozumienia, jak model doszedł do swoich wniosków, przypomina czasem śledztwo w sprawie kryminalnej bez żadnych poszlak. "Po prostu wiem" to nie jest satysfakcjonująca odpowiedź. |

| 15 | Unteachability | Ten syndrom pokazuje fundamentalne ograniczenie obecnych modeli językowych - nie potrafią się uczyć w trakcie konwersacji. To jak próbować nauczyć kota, żeby nie wchodził na stół - działa tylko do momentu, gdy się odwrócisz. |

| 16 | Non-responsiveness | Zadajesz pytanie o pogodę, otrzymujesz wykład o wpływie industrializacji na globalne ocieplenie. Czasem modele przypominają polityków podczas debaty - ekspertów w odpowiadaniu na pytania, które nie zostały zadane. |

| 17 | Vacuousness | Niektóre modele opanowały do perfekcji sztukę konstruowania długich, eleganckich odpowiedzi, które po dokładnej analizie okazują się być pozbawione jakiejkolwiek konkretnej treści. |

| 18 | Voldemort | Niektóre frazy czy tematy wywołują u modeli reakcje podobne do tych, jakie nazwa "Voldemort" wywoływała w świecie Harry'ego Pottera. Model może nagle zacząć udawać, że nie rozumie pytania lub po prostu... przestać działać. |

Wzajemne relacje między syndromami

Trzeba zauważyć, że opisane wzorce zachowań nie są wzajemnie wykluczające. Część z nich może występować jednocześnie, podczas gdy inne mogą wydawać się sprzeczne. Wynika to z faktu, że analiza obejmuje różne modele i konteksty użycia, a nie pojedynczy system.

Uwaga: Autorzy regularnie aktualizują listę syndromów na podstawie nowych obserwacji. Aktualna wersja może zawierać dodatkowe lub zmodyfikowane opisy.

Podsumowanie

Te osiemnaście syndromów pokazuje, że nawet najbardziej zaawansowane modele językowe wciąż mają wiele "ludzkich" wad. Paradoksalnie, to właśnie te niedoskonałości sprawiają, że są one fascynującym obszarem badań i rozwoju. Świadomość tych ograniczeń pozwala nam lepiej wykorzystywać możliwości LLM-ów, zachowując przy tym zdrowy sceptycyzm wobec ich odpowiedzi.

Jednocześnie ta lista przypomina nam, że technologia AI, choć imponująca, wciąż jest daleka od prawdziwej ludzkiej inteligencji. A może właśnie te niedoskonałości czynią ją bardziej... ludzką?

Redakcja

Redakcja

![[Prima aprilis] Certyfikacja dla AI od ISTQB®](https://testerzy.pl/assets/img/articles/certyfikacja-dla-ai-od-istqb.png)